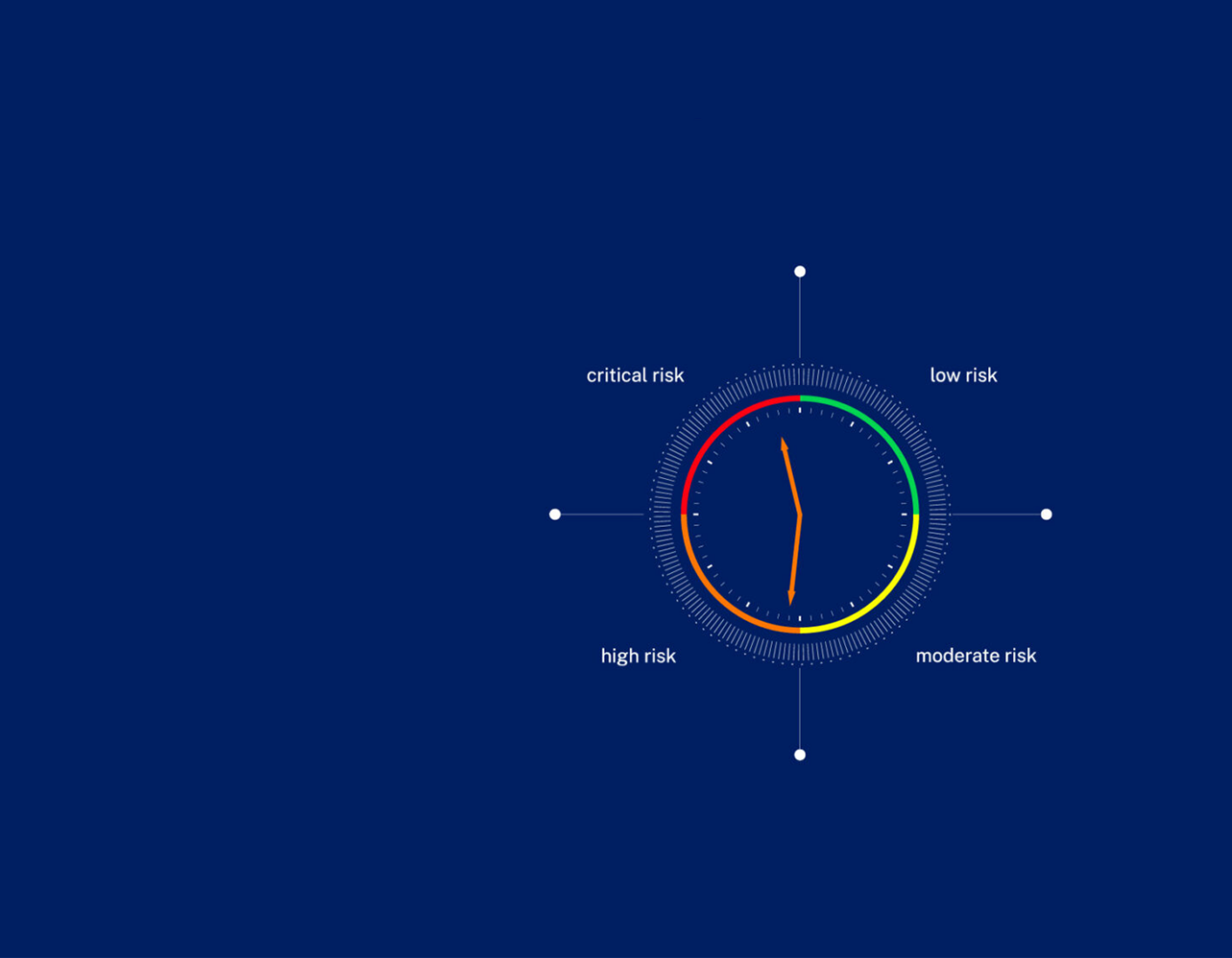

Les préoccupations concernant l’évolution rapide de l’IA ont déclenché une crise de confiance, allant des craintes de pertes d’emplois aux questions philosophiques sur l’avenir de l’humanité. En réponse, Michael Wade et l’équipe du TONOMOUS Global Center for Digital and AI Transformation à Lausanne ont créé l'”Horloge de Sécurité de l’IA de l’IMD” pour offrir de la clarté aux décideurs politiques et aux dirigeants d’entreprises. Se déplaçant entre 23h00 et minuit, l’horloge mesure à quel point nous sommes proches de l’Intelligence Artificielle Générale Incontrôlée, des systèmes qui pourraient fonctionner en dehors du contrôle humain avec le potentiel de causer des dommages significatifs à l’humanité.

L’équipe de Wade s’appuie sur environ 4500 sources pour surveiller les changements technologiques et réglementaires, des développements dans les grands modèles de langage, les puces, l’IA agentique, l’armement, la robotique et les infrastructures critiques, aux cadres réglementaires mondiaux et nationaux en évolution et aux politiques d’entreprise des principaux développeurs d’IA. “L’Horloge de Sécurité de l’IA de l’IMD est conçue pour sensibiliser, non pour alarmer,” déclare Wade. “En communiquant clairement ces risques, l’horloge sert d’outil pour rendre les questions complexes plus compréhensibles et exploitables, guidant les mesures nécessaires pour assurer le développement responsable de l’IA.”

Quelle heure est-il ?

Depuis son lancement en septembre 2024, l’horloge a avancé de cinq minutes vers minuit – à 23h36 dans la zone à haut risque. Le dernier ajustement, en février, a été déclenché par des facteurs tels que la montée des modèles open source comme DeepSeek et des agents IA semi-autonomes comme OpenAI Operator, les plans de dépenses massives en IA des États-Unis et de la Chine, et les mesures américaines visant à abroger les législations offrant une protection contre les risques liés à l’IA. Ces événements, couplés à une réglementation mondiale généralement faible, soulèvent des préoccupations quant à l’IA opérant au-delà du contrôle humain, soulignant le besoin urgent de mesures de sécurité renforcées pour atténuer les risques.

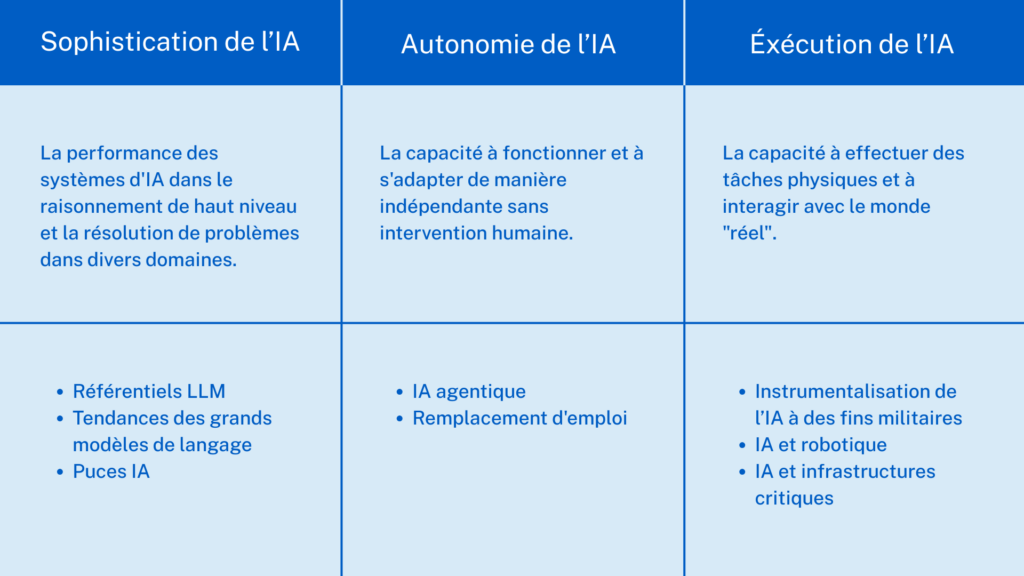

Les mécanismes internes de l’horloge de l’IA

La lecture de l’horloge reflète une analyse approfondie de trois piliers de l’IA : sophistication, autonomie et capacité d’exécution.

Plus près de minuit : un appel à l’action

Le nombre alarmant de développements récents et significatifs en matière d’IA illustre le rythme accéléré du changement. Cette évolution rapide souligne une réalité inquiétante : de nombreuses mises à jour ont augmenté le profil de risque de l’IA. Pour l’équipe de Wade, le développement de l’IA doit être soumis à une réglementation robuste. Selon les experts, il reste une opportunité de mettre en place des mesures de protection, mais la fenêtre d’action se referme rapidement. Il est impératif que les avancées technologiques soient alignées avec la sécurité sociétale et les valeurs éthiques pour atténuer les risques croissants.

Texte tiré de : A wake up call : the AI clock is ticking, I by IMD, Issue 17 March 2025, p.38-39.